Tech 4 Climate : le numérique s’engage pour le climat

La conférence Tech 4 Climate interroge le rôle du numérique dans le contexte de la crise écologique. Avec en toile de fond un défi pour tous les acteurs de la tech : comment réconcilier l’accélération numérique et les défis environnementaux auxquels nous faisons face ?

Le 13 juin dernier, Tech 4 Climate a réuni à la Maison de la Chimie des intervenants variés, réunis autour d’une journée organisée en deux parties. Après une matinée consacrée à la prise de conscience sur les impacts du réchauffement climatique, le programme de l’après-midi s’est attelé à imaginer des solutions à travers des ateliers thématiques autour du numérique responsable, de la CSRD, du financement de la transition ou du rôle de l’IA.

- Crédit photos : Anna Ellouk

- Replays : https://tech4climate.paris/replay-tech-for-climate-2024/

Le constat : nous ne pouvons plus ignorer la nécessité d’une gestion durable des ressources consommées par la transformation numérique. Cependant, la transition peut accélérer en s’appuyant sur le numérique, en tirant parti de sa puissance, mais aussi de sa capacité à faciliter la coopération entre les acteurs. Mais nous devons repenser les priorités, et hiérarchiser les usages. A ce titre, notons d’ailleurs que Tech 4 Climate établit chaque année son propre bilan carbone (transport, traiteur).

Ecran noir, musique angoissante (issue des dossiers de l’écran) : contre toute attente, c’est document INA de 1976 qui ouvre la journée. René Barjavel y expose sa crainte de la vulnérabilité de notre monde “électronique”, qui dépend totalement de la circulation de l’énergie.

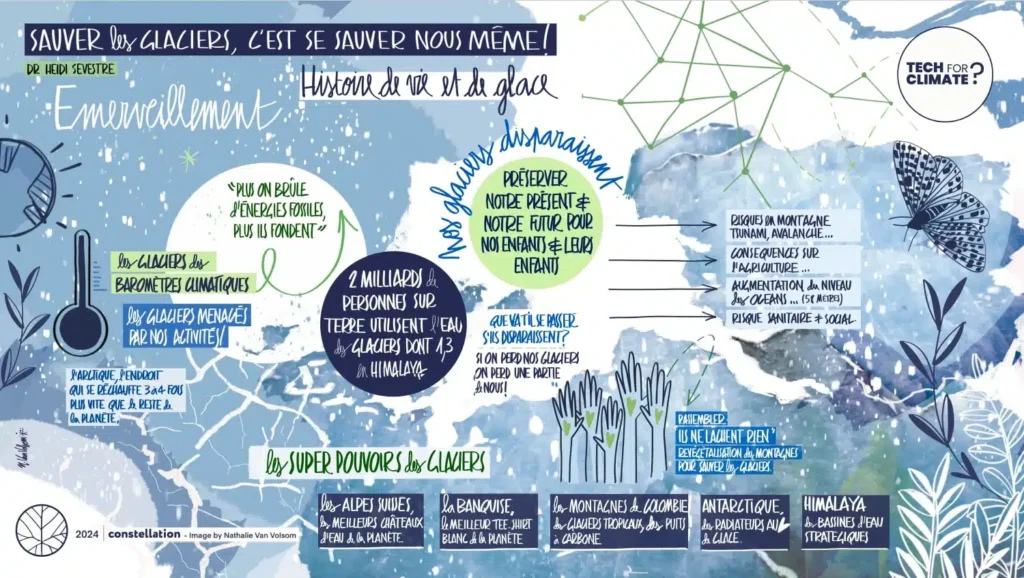

Après cette entrée en matière glaçante, c’est justement le Dr Heidi Sevestre, glaciologue et Secrétaire général de l’AMAP, le programme de surveillance et d’évaluation de l’Arctique, qui prend le micro. Avec une énergie et un enthousiasme communicatifs, Heidi évoque son parcours de glaciologue et sa passion pour la montagne.

Histoires de vies et de glaces

Malheureusement, les nouvelles ne sont pas bonnes. Nous le savons déjà en partie, mais Heidi Sevestre apporte la preuve en photos et en simulations : au fil des décennies, on constate l’alarmante fonte de la calotte glaciaire, celle des grands glaciers, et les conséquences dramatiques que cela peut avoir sur les environnements de montagne, comme les tsunamis de montagne. Il s’agit d’une “vidange brutale d’un lac glaciaire”, comme cela est arrivé dans l’Himalaya en 2021.

On apprend également que l’eau des glaciers est utile notamment pour maintenir le débit des fleuves en été, ou encore refroidir les centrales, et que 2 milliards de personnes sur terre utilisent l’eau des glaciers pendant au moins une partie de l’année. Quant à la calotte glaciaire, elle agit comme le “t-shirt blanc” de la planète, en renvoyant une partie de l’énergie solaire. C’est donc notre meilleure arme contre le réchauffement, or le réchauffement contribue à diminuer la couverture de glace, conduisant ainsi à… plus de réchauffement.

Malgré la noirceur du constat, la keynote d’Heidi Sevestre se veut porteuse d’espoir : à travers les histoires des glaciers qu’elle conte, ce sont aussi les vies des passionnés qu’elle rencontre, et qui à leur échelle, contribuent à lutter contre le réchauffement et documentent inlassablement l’évolution des glaciers.

En quoi l’IA peut-elle contribuer à faire face aux défis environnementaux ?

L’IA est partout, des agendas des DSI aux pratiques des usagers. Si cette généralisation des usages soulève naturellement la question de l’impact environnemental, l’IA peut aussi être porteuse de solutions.

Deux tables rondes étaient consacrées à ce sujet.

IA : pouvoirs, devoirs et nuisances

Intervenants :

- Annabelle Blangero, Lead of Responsible AI, Senior Manager Ekimetrics

- Pierre-Etienne Pommier, CEO & fondateur d’Arago

- Emmanuelle Bernardin, Head of Data & AI, Digital Employee experience, GA Digital Programme chez Rothschild & Co

Le premier sujet abordé est celui de la fiabilité de l’information. Avec la démocratisation des outils d’IA générative, il devient de plus en plus difficile juger de la qualité d’une information. Entre fake news, information biaisée, tronquée, voire hallucinations du LLM, comment faire la part des choses ? Pierre-Etienne Pommier préconise de constituer des bases d’informations en commun : partager sources, données et méthodes afin de limiter les risques d’informations erronées qui seront ensuite diffusées par Chat GPT ou Google. Le fait est que les LLM hallucinent, et qu’ils le feront toujours, donc il faut trouver comment composer avec ce défaut.

Cela suppose aussi de disposer d’outils, de formations, d’un bagage technique, afin de savoir déceler les hallucinations. Vérifier, recouper les sources, n’est pas une évidence pour tous les utilisateurs. Si la presse est aujourd’hui en crise, celle-ci pourrait encore s’aggraver si l’information perd de sa valeur, car alimentée par des hallucinations. La course à l’information, combinée à l’introduction de l’IA dans les moteurs de recherche pour en faire des moteurs de réponse, pourrait avoir des impacts dévastateurs.

D’après une étude de Newswatch, il y aurait déjà plus de sites d’actualités locales générés par IA que de sites réels (1700 sites IA). C’est un enjeu économique pour la presse, et un enjeu démocratique pour le grand public.

Annabelle Blangero a ensuite présenté un système multi agents qui répond à cet enjeu de multiplication des sources. “Claire” permet ainsi d’obtenir 3 réponses en parallèle sur les risques de l’IA, en synthétisant des données issues de bases légales, de livres blancs et de ressources techniques. La réponse obtenue couvre ainsi les aspects légaux, techniques et sociaux, en citant ses sources, issues d’un corpus évolutif.

Rotschild & Co, qui propose des services financiers, s’est organisé pour adresser les risques liés à l’IA. Comme l’explique Emmanuelle Bernardin, ils ont développé en interne un outil basé sur le RAG, afin de prévenir la fuite de données dans leur environnement Cloud privé. Avec la recrudescence d’outils IA chez leurs fournisseurs de services, il est essentiel pour l’entreprise de clarifier les règles d’usage des outils IA. De même, l’IA Act oblige Rotschild & Co à repenser son approche des risques.

Cette démarche proactive présente cependant certaines difficultés, comme de rassembler les compétences nécessaires à un groupe de travail dédié à l’IA responsable : sécurité IT, legal & compliance, digital & data, architecture IT…

Autre point d’attention : comment ne pas rendre le processus trop lourd, quand on ne dispose pas en interne des compétences pour évaluer les sujets d’IA responsable. L’entreprise a sollicité un accompagnement externe pour produire une grille basée sur 8 risques, dont le risque environnemental. Malgré tout, les modèles d’IA générative étant peu transparents, cet aspect est encore difficile à évaluer.

Copyright et propriété intellectuelle sont également un risque à adresser : l’entreprise ne peut pas se permettre d’utiliser une image dont elle n’a pas la propriété intellectuelle. Dall E par exemple ne permet pas de savoir si une image a été plagiée; Getty propose une base copyrightée, mais avec moins de choix pour les utilisateurs. Il faut donc trouver le bon équilibre entre une bonne gestion des risques et ce qu’on autorise, tout en maintenant son avantage concurrentiel : d’autres entreprises n’ont pas forcément les mêmes scrupules.

La table ronde s’est terminée par une question ouverte sur le bon usage de l’IA et l’IA frugale. Une question qui reste en suspens quand de nombreuses entreprises utilisent l’IA pour augmenter la production.

Comment la data et l’IA peuvent-elles être un levier de performance durable pour les organisations ?

Intervenants :

- Laurent Felix, DG Ekimetrics

- Thomas Cottinet, Directeur d’ECOLAB, Ministère de l’Environnement

Comme l’explique Laurent Felix, si l’IA apporte beaucoup dans l’optimisation, elle peut aussi conduire à des modèles non vertueux comme Shein. Il existe aussi des exemples vertueux d’usage de l’IA, le plus souvent orientés autour de trois leviers : la mesure, l’optimisation, et la transformation des filières.

Laurent Felix cite l’exemple d’Action Logement, le premier bailleur social de France avec 1,1 million de logements, qui utilise l’IA pour mieux connaître son patrimoine, et notamment réduire la consommation d’électricité, d’eau, et augmenter l’attractivité des bâtiments.

300 données sont collectées par bâtiment, ce qui représente un long travail sur la gouvernance des données.

Thomas Cottinet a ensuite présenté un cas d’usage lié à la mesure de l’artificialisation des sols dans le Val d’Oise. Malgré la prise de conscience suite au rapport du GIEC, et les objectifs de zéro artificialisation posés par la Convention citoyenne du Climat, on est passé de 64 hectares artificialisés par an entre 2012 et 2017 à 180 hectares par an entre 2017 et 2022. Là encore, pour pouvoir agir et atteindre les objectifs, il est nécessaire de connaître le territoire, et donc de disposer des bonnes données.

Le projet mené conjointement par Ecolab et l’IGN vise donc à analyser une masse incroyable de photos, à l’échelle de la France entière, et d’en tirer une documentation précise de l’affectation des sols à quelques centimètres près. Ce projet, qui mobilise Data et IA, permet de parvenir à 75% d’affectations correctes avant intervention humaine. Ici l’IA permet donc d’accélérer l’émergence de ce référentiel, et d’en faire un outil de prise de décision.

Sur un sujet équivalent, nous avons mené un projet de plateforme Data/ ML Ops avec CLS, visant à industrialiser le processus de classification des images satellites du territoire – à lire en détail ici.