Dans ta science : Caroline Chopinaud, Hub France IA

A la croisée de plusieurs disciplines, la Data Science s’appuie sur des méthodes et des algorithmes pour tirer des informations et de la connaissances à partir de données structurées et non structurées. Encore inconnus il y a quelques années, les métiers de la Data Science et du Machine Learning évoluent très vite. Compétences, méthodes, outils… dans cette série d’entretiens, nous confrontons notre expérience à celle du marché, avec la participation de Data Scientists et spécialistes de l’IA externes à Devoteam Revolve.

Nous recevons aujourd’hui Caroline Chopinaud, Directrice associée du Hub France IA. Passionnée par l’Intelligence Artificielle, Caroline travaille depuis plus de 15 ans à faire de la recherche dans ce domaine une réalité business concrète.

Pouvez-vous présenter votre parcours ?

Après mes études en informatique et en mathématiques et un doctorat en Intelligence Artificielle dans le domaine des systèmes multi-agents, j’ai rejoint la PME MASA Group qui conçoit des simulateurs d’entraînement pour la défense et la sécurité civile. Il s’agit de systèmes qui utilisent l’IA pour animer des personnages autonomes dans des simulations constructives, de type jeu de stratégie, où chaque unité sur le terrain est pilotée par un agent. On ne parlait pas de Machine Learning à ce moment là, c’étaient ce qu’on appelle des IA symboliques, car l’objectif était de modéliser des doctrines militaires, pour lesquelles il n’y a pas de données, mais des règles métiers à appliquer dans les systèmes, avec des notions d’adaptation des comportements en fonction des interactions entre les agents, avec l’environnement et les utilisateurs.

En 2014, j’ai monté avec plusieurs associés la startup Craft AI. Nous voulions concevoir une API avec un algorithme de Machine learning capable d’apprendre des comportements fondés sur l’analyse de séries temporelles. Les cas d’usage étaient nombreux et une telle solution n’existait pas à l’époque. Et en 2020, j’ai quitté Craft AI pour rejoindre Hub France IA.

Quels sont les objectifs de Hub France IA ?

Hub France IA est une association qui a pour but de fédérer l’écosystème français de l’IA, avec la volonté de le valoriser au niveau national et européen. Nous sensibilisons les entreprises à l’usage de l’IA, et nous mettons en avant les technologies françaises ou européennes autour de l’IA. Nous voulons donner aux entreprises qui ne sont pas encore matures sur ce sujet une meilleure compréhension de ce que l’IA peut leur apporter, et comment l’IA peut être bénéfique pour leur activité. La technologie est là, elle est opérationnelle, et elle permet de déployer l’IA dans des projets cœur de métier.

Si j’ai rejoint Hub France IA, c’est parce qu’il me semble essentiel de faire cette démarche de promotion de l’écosystème et d’acculturer les entreprises à l’IA pour leur permettre de lancer de vrais projets. Nous ne sommes pas dans cette démarche qui consiste à multiplier les POC sur l’IA, nous voulons sensibiliser sur la réelle finalité des projets d’IA, concrets et impactants. Il existe d’ailleurs de nombreuses possibilités de financement des projets d’IA sur tous les secteurs, santé, agriculture, industrie 4.0, etc.

Quelle est la maturité du marché en France ?

Le positionnement par rapport à la concurrence américaine est compliqué. Nous avons pourtant des acteurs européens de plus petite taille, et qui proposent des solutions efficaces. Une des missions du Hub France IA est de cartographier ces acteurs, qui sont souvent des start up ou des scale up. Peut-être sont-ils trop nombreux d’ailleurs, et il y aurait un intérêt à les regrouper sur certains sujets pour être plus forts face aux GAFAM, souvent perçus comme le fournisseur idéal car ils offrent des solutions clés en mains. Sur des réponses à appels d’offres, les GAFAM l’emportent souvent au détriment d’acteurs plus petits, qui se sont pourtant verticalisés sur des domaines précis, et dont la solution, la technologie est souvent meilleure qu’une solution généraliste.

Les PME sont une cible compliquée à atteindre : elles ne sont pas matures pour le sujet, connaissent mal l’IA, sont parfois en retard sur les sujets numériques

Quelles sont les solutions ?

Nous avons de nombreuses ressources mais l’écosystème est encore mal valorisé, c’est pour cette raison que nous nous efforçons de le rendre plus visible, et plus lisible, pour les acheteurs potentiels. Les PME sont le cœur de cible des financements européens, pourtant elles sont encore très en retard sur le sujet. Nous ciblons ces acteurs, mais c’est encore compliqué, ils sont très proches de leur métier, et ne voient pas forcément ce que l’IA peut leur apporter. Notre challenge est de comprendre leur métier, et voir où y intégrer de l’IA qui puisse générer un retour sur investissement direct.

A titre d’exemple, nous pilotons le programme de la région Ile de France Pack IA, pour aider les entreprises à accélérer sur l’IA. Il s’agit d’un programme de 3 mois, à hauteur de 37 000 euros, dont 50% sont financés par la région. Nous menons régulièrement des entretiens de cadrage avec les entreprises potentiellement intéressées, et concrètement, on ne leur parle pas d’IA. On essaie plutôt d’identifier les irritants métier, pour ensuite déterminer où on pourrait mettre de l’IA. Nous faisons ensuite la mise en relation avec les sociétés de conseil ou les start up qui vont réaliser le projet conjointement avec la PME. Néanmoins, les PME sont une cible compliquée à atteindre : elles ne sont pas matures pour le sujet, connaissent mal l’IA, sont parfois en retard sur les sujets numériques. Avant d’arriver à l’IA, il y a des paliers de transformation numérique.

Quels sont les principaux freins ? Le coût ? Les idées reçues sur l’IA ?

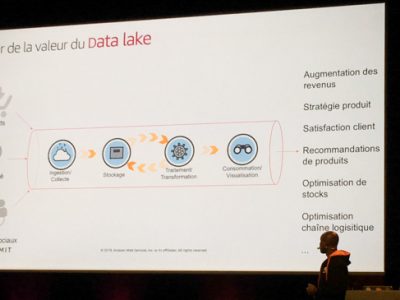

Certaines entreprises ne connaissent pas du tout l’IA. D’autres sont plus au fait des possibilités, mais ne savent pas avec qui travailler, ou n’ont aucune idée des délais. Il y a beaucoup d’idées reçues, comme le fait qu’un projet d’IA soit nécessairement un projet de grande ampleur, à effet tunnel, avec des datalakes, des tonnes de données à traiter… Nous essayons de montrer qu’on peut mettre en place une technologie d’IA simple, un premier projet rapide avec un impact concret. D’autres idées reçues ont la vie dure : l’IA va remplacer nos métiers, elle n’amène pas de bénéfices directs, on nous vend du rêve, etc. Toutes ces années à faire des POC sans suite n’aident pas à revaloriser l’image de l’IA, pourtant 3 mois sont suffisants pour développer un MVP qui passera en production. Nous avons ainsi pu faire financer plus de 30 projets depuis le lancement du dispositif.

Où en sommes-nous sur l’industrialisation et le ML Ops ?

En France, on commence à avancer sur le sujet, certaines sociétés se positionnent sur l’accompagnement à l’industrialisation. Cela a longtemps été un frein, principalement pour deux raisons. Tout d’abord, l’accès à la donnée : elle existe, mais personne ne sait comment aller la chercher et comment l’exploiter. Puis, le passage en production. Travailler sur des modèles, expérimenter, tout le monde peut le faire, mais dès qu’il faut industrialiser, et donc gérer du versioning et du réentraînement, c’est plus compliqué. Les DSI ne sont pas toujours au fait de ce qu’il faut faire en IA, et projettent beaucoup de complexité, alors que ce sont juste des projets informatiques, avec certaines spécificités.

C’est pour cette raison qu’on est longtemps resté sur des phases de POC, avec des cellules innovation qui testent des idées, mais qui ne sont jamais concrétisées par la DSI parce que personne ne veut s’en occuper. Le ré-apprentissage est un vrai sujet, mais il s’agit “juste” d’un autre pipeline. Nous avons au Hub France IA par exemple des start up spécialisées dans le déploiement des modèles de NLP (Natural Language Processing), capable de gérer les besoins en infrastructure et les montées en charge. Plusieurs acteurs se positionnent sur ce sujet d’industrialisation, cela permet de lever des verrous et de faire avancer les projets.

Que doit-on attendre de la réglementation européenne de l’IA ?

Nous avons étudié cette réglementation dans le cadre de plusieurs groupes de travail : avec les banques membres de notre association, mais aussi avec le Groupe La Poste et La villa numeris (voir ici le communiqué), et avec des start-up, et aussi avec nos partenaires européens de l’EAIF.

Globalement, il y a dans cette réglementation de nombreuses approximations dans les termes, et cela génère de l’incompréhension. Par exemple, qui porte la responsabilité de l’application de la réglementation, entre le fournisseur et l’acheteur ? Cela pose problème aux fournisseurs d’IA qui ne savent pas comment va être utilisée leur technologie, quand les grands groupes vont considérer que ce n’est pas à eux de gérer cela. Cette réglementation apporte trop d’incertitudes, d’autant plus que le périmètre adressé est très large. On y intègre même les statistiques, ou des systèmes de règles qui sont déjà en place dans les entreprises depuis longtemps, qui sont déjà industrialisés et pour lesquels il n’y a pas de risque particulier. Par ailleurs, la réglementation n’est pas vraiment orientée sur les usages, on cible la technologie de façon un peu floue. Par exemple, si la détection faciale est interdite dans l’espace public, ce n’est pas une question de technologie, mais c’est bien l’usage qui doit être interdit, quelle que soit la technologie utilisée. Pourtant, ce n’est pas ainsi que la réglementation est conçue. J’ai le sentiment que pour les secteurs qui ne sont pas encore matures sur l’IA, comme les RH, la réglementation va être un frein à l’innovation. Pour résumer, l’accueil est très critique en termes de coûts, de modèle de responsabilités, ou de freins à l’adoption de l’IA.

Ces contraintes pèseront plus sur la France et l’Europe que sur les grands acteurs internationaux, qui trouveront les moyens de déjouer ces exigences.

Il y aussi un volet sur la mise en place de bonnes pratiques autour du traitement de données et du stockage des modèles, mais on ne sait pas s’il est contraignant et s’il y aura des sanctions pour les entreprises ne respectant pas ces guidelines. La réglementation spécifie aussi qu’il faudra être en mesure de rejouer tout l’historique des IA et des modèles déployés, ce qui implique de stocker données et modèles sur toute la vie d’un système. Outre l’impact lourd en termes de stockage, cela ajoute beaucoup de complexité à la gestion du cycle de vie des modèles. On voit mal comment cela peut être opérationnalisable dans le cas de modèles auto apprenants.

Et sur la question des données, reste à voir qui en France portera le sujet ? Dans le secteur bancaire, ce serait probablement l’ACPR. Quoiqu’il en soit, cela signifie certainement que ces contraintes pèseront plus sur la France et l’Europe que sur les grands acteurs internationaux, qui trouveront les moyens de déjouer ces exigences.

Quels sont les enjeux de l’éthique et de l’IA ?

Notre groupe de travail sur l’éthique réfléchit justement à comment opérationnaliser ces concepts. Il faut comprendre ce qu’il y a derrière l’éthique de l’IA, les enjeux sont multiples : on touche aux notions de robustesse, de l’implication de l’humain, de l’usage final du système, ou au fait que le système fait ce pour quoi il a été conçu.

Traiter de l’éthique dans l’IA peut se faire de différentes manières : la mise en place de comité d’éthique, le développement d’outils en interne pour évaluer le niveau d’éthique d’un système, mais je ne crois pas qu’aujourd’hui nous soyons très avancés sur ces sujets. Il y a différentes démarches de labellisation, comme Label IA, Occitanie Data (Etikia), Numeum et le Ethical AI qui est un guide pratique de mise en place des systèmes d’IA. De nombreuses initiatives donc, mais la question est de savoir comment elles se traduisent concrètement d’un point de vue opérationnel ? Comment diffuser ces bonnes pratiques, à la fois aux interlocuteurs métiers quand ils expriment leurs besoins en IA, qu’au Data Scientists quand ils construisent les modèles et intègrent les biais, et ce tout au long du cycle, de la conception au build et au run. Tous les acteurs de la chaîne de valeur de l’IA sont impactés, mais pour le moment ils ne sont pas tous impliqués dans cette réflexion.

Plus généralement, au sein de notre groupe de travail les participants ont la crainte que les gens se dédouanent dès qu’il s’agit d’IA. En d’autres termes, “si l’IA prend la décision, je n’ai plus de responsabilité”. Ce n’est pas vrai, le système fournit des inputs, et la décision revient à l’humain. Il lui appartient donc de prendre assez de recul pour pondérer ce que lui retourne le système. Le problème, c’est que l’inconscient collectif fait peser beaucoup de peurs et d’idées reçues sur l’IA. Au niveau du Hub France IA, nous travaillons sur un glossaire pour définir un certain nombre de termes liés à l’éthique de l’IA, avec toute une partie sur l’inclusion de l’humain dans la boucle. Il est essentiel que les utilisateurs finaux de systèmes qui embarquent de l’IA soient conscients de leur responsabilité dans les actions du système.

D’où l’importance de l’explicabilité des modèles ?

C’est un sujet qui revient souvent, en effet les entreprises ne souhaitent pas avoir une boîte noire dont elles ne comprennent pas le fonctionnement. Néanmoins, l’explicabilité est un sujet complexe, l’explicabilité peut être au niveau global, local. On parle aussi d’interprétabilité : est-ce qu’on peut interpréter les décisions du système ? Ou avoir une vision globale de ce qu’est le modèle ? On aura par ailleurs différents niveaux d’explicabilité en fonction des interlocuteurs : un data scientist a besoin de comprendre le modèle et comment il prend ses décisions, quand l’utilisateur sera un autre niveau d’information.

Si la question de l’explicabilité est récurrente, ce n’est pas la seule solution. On peut très bien avoir un modèle “boite noire”, mais dont le comportement est acceptable et monitoré au fil du temps, à défaut de pouvoir en comprendre les tenants et aboutissants.

L’IA est-elle compatible avec le Green IT ?

On sait que la mise en œuvre de l’IA a un impact positif sur l’environnement. Les cas d’usage sont nombreux, et on essaie de valoriser ces initiatives, car l’IA a encore une image négative et les a priori sont nombreux. Évidemment, la question qui fait débat, c’est l’impact de l’IA sur la consommation énergétique. Sur le sujet, nous n’avons pas de mesure fiable qui prenne en compte l’ensemble des paramètres : les flux de données, leur stockage, l’infrastructure Cloud ou on premise, Edge ou pas, etc.

Au niveau du Hub France IA, nous menons une réflexion sur l’optimisation du cycle de vie des projets d’IA pour réduire leur impact environnemental. Il y a déjà des travaux de recherche qui ont été faits sur le sujet, des bonnes pratiques, et nous avons lancé une action de bibliographie dans notre Groupe de Travail Environnement. Nous espérons a minima pouvoir identifier les bonnes pratiques. Certaines relèvent du simple bon sens, ça commence par éteindre ses serveurs la nuit quand ils sont inutilisés ! Sensibiliser les utilisateurs à la question du coût peut les amener à réfléchir sur l’impact environnemental. Il faut se poser la question de la nécessité : doit-on toujours utiliser autant de données, ré-entraîner plusieurs modèles pour trouver le meilleur ? On teste souvent sans se préoccuper de l’impact environnemental de l’IA, d’autant plus que le coût du calcul a beaucoup baissé.