Dans ta science : l’apport du Machine Learning dans le diagnostic du cancer du poumon

A la croisée de plusieurs disciplines, la Data Science s’appuie sur des méthodes et des algorithmes pour tirer des informations et de la connaissances à partir de données structurées et non structurées. Encore inconnus il y a quelques années, les métiers de la Data Science et du Machine Learning évoluent très vite. Compétences, méthodes, outils… dans cette série d’entretiens, nous confrontons notre expérience à celle du marché, avec la participation de Data Scientists et ingénieurs Machine Learning externes à Devoteam Revolve.

Nous recevons aujourd’hui Stéphanie Lopez, Data Scientist et Principal Investigator sur un projet collaboratif d’aide au diagnostic du cancer du poumon.

Stéphanie Lopez est ingénieure en Mathématiques appliquées, spécialité Computer Vision et Machine Learning, et Docteur dans l’indexation d’images par le regard. Stéphanie travaille aujourd’hui comme Data Scientist et Principal Investigator sur le projet collaboratif d’aide au diagnostic du cancer du poumon grâce à l’IA, Lung Screen AI, projet mené conjointement avec l’université Côte d’Azur, le CHU de Nice et une start-up.

Qu’est-ce qui caractérise le métier de Data Scientist selon vous ?

C’est un métier qui m’a permis de réaliser mes rêves, mais différemment. Quand j’étais plus jeune, je voulais sauver le monde, devenir médecin et améliorer la vie des autres, mais je n’avais pas les capacités en biologie. Je n’ai pas pu réaliser ce rêve, mais le projet Lung Screen AI me permet de mettre mes compétences en Machine Learning au service du médical, en aidant les radiologues à mieux dépister le cancer du poumon.

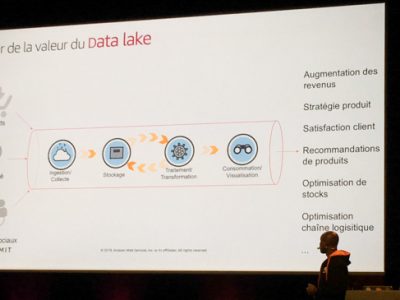

Plus concrètement, le terme Data Scientist regroupe selon moi différentes réalités : des compétences en mathématiques, en informatique, la capacité à élaborer une stratégie qui puisse répondre à un problème, et celle de rendre le résultat compréhensible grâce à la data visualisation. Le Data Scientist a donc une vision globale d’un projet d’IA, et si le budget le permet, on va pouvoir lui faciliter la tâche en intégrant un Data Manager pour la préparation des données, un Data Engineer pour l’infrastructure, un Dataviz, etc. Une fois que le pipeline initial est bien en place, le Data Scientist peut être secondé par d’autres métiers.

Quelle est votre organisation sur ce projet ?

Au départ, j’étais la seule ingénieure recrutée sur ce projet, grâce à un fond IDEX d’Université Côte d’Azur, UCA JEDI. Dans un premier temps, je me suis familiarisée avec le problème métier, j’ai échangé avec les radiologues du CHUN, partenaire du projet, pour identifier leurs besoins. J’ai récupéré des données que j’ai analysées comme un radiologue le ferait, pour ensuite les traiter dans un algorithme. J’ai mis en place tout cela au démarrage du projet, puis j’ai eu l’opportunité d’obtenir des financements en répondant à différents appels à projet qui m’ont permis d’embaucher une équipe, au bout de 4 ans.

Quelles sont les contraintes du cas d’usage du dépistage du cancer du poumon ?

Nous sommes dans le cadre très particulier de l’IA en santé. On sait que l’IA a beaucoup à apporter dans le parcours de soins, mais le nerf de la guerre, ce sont les données ! Il existe un historique de données issues des hôpitaux, mais elles ne sont pas structurées pour être exploitées par le Machine Learning. Le premier challenge est donc de récupérer des données, tout en se conformant à la réglementation et en garantissant l’anonymat et la sécurité des patients. Une fois cette difficulté surmontée, on travaille sur la structuration des données, de manière à ce qu’elles soient dans le bon format pour être utilisées dans le logiciel. Cela prend un certain temps.

Quel est l’apport de l’IA dans le dépistage ?

On cherche un objet dans une image : un nodule, ce sont des billes de quelques pixels dans une image qui en compte plusieurs millions. Détecter le nodule est une tâche assez complexe pour l’œil expert du radiologue, mais avec suffisamment de données on peut l’apprendre à un algorithme. L’IA va permettre au radiologue de passer moins de temps à identifier ces pixels, pour se concentrer sur la caractérisation de la malignité et focaliser son expertise sur les préconisations de suivi. Il faut savoir qu’un nodule supposé malin entraîne des examens invasifs pour le patient. Il faut éviter de rappeler des patients qui n’ont pas le cancer tout en identifiant les cas de cancer à un stade précoce, d’où l’importance de consacrer du temps à cette phase plutôt qu’à l’analyse préliminaire des radios.

L’algorithme doit donc caractériser la malignité des nodules pulmonaires. Pour cela, nous nous appuyons sur l’état de l’art des algorithmes ayant fait leurs preuves dans d’autres communautés, et qui ont été développés en disposant de données pré-annotées. La phase d’annotation peut être très chronophage, et nous revenons ensuite vers les radiologues pour vérifier la validité des données, s’assurer de ne pas se tromper. Nous devons ensuite être en mesure de leur expliquer les résultats de l’algorithme, avec leur propre vocabulaire et leurs critères. C’est un peu expliquer l’inexplicable, parce que le deep learning et les réseaux de neurones fonctionnent un peu comme une boîte noire.

De quelles données disposez-vous actuellement ?

Le contexte du cancer du poumon est assez particulier. C’est un enjeu mondial, il s’agit de la première cause de mortalité par cancer. De nombreuses études prouvent l’importance du dépistage, qui permet de réduire la mortalité de 25%. Nous disposons donc déjà de données collectées par de grands organismes de santé, potentiellement déjà pré-structurées pour des études statistiques, et donc anonymisées. Cela nous a permis de gagner du temps sur la partie réglementaire, pour nous concentrer sur le cœur du problème, c’est-à-dire associer des images à une information : où sont positionnées les nodules, sont-ils malins ou bénins ?

Comment les médecins perçoivent-ils l’apport de l’IA ?

Il est nécessaire de passer par une phase d’explicabilité du modèle. Le médecin peut craindre que l’IA lui “vole” son travail, alors que ce n’est qu’un outil d’aide à la prise de décision. A contrario, il peut y avoir l’effet inverse, une confiance trop grande dans l’IA, avec le risque de déresponsabiliser. Nous expliquons donc pourquoi potentiellement les résultats sont tels qu’ils sont, pourquoi certains éléments dans l’image ne sont pas identifiables par l’œil, mais peuvent être extraits par l’algorithme, pour ensuite être traduits en termes humains, afin de permettre au médecin de prendre une décision éclairée. C’est aussi dans cette optique que j’ai lancé sur mon temps libre avec une amie le podcast Horizon IA, afin de mieux expliquer les enjeux de l’IA et la responsabilité de l’humain dans ce contexte.

Quelle serait la concrétisation de ce projet ?

Bien que le cancer du poumon soit la première cause de mortalité par cancer, il n’y a pas de dépistage systématique organisé du cancer. Les obstacles sont nombreux : pas assez de scanners en France par rapport au nombre de personnes éligibles, tension dans les effectifs des radiologues au vu du nombre d’analyses à assumer… Par ailleurs, un dépistage positif (ou un faux positif) implique de nombreux autres corps de métier qui pourraient être sursollicités dans le cas de faux positifs : oncologues, pneumologues, chirurgiens thoraciques… Ce sont des problèmes majeurs qu’il faut pallier, et nous voulons gagner du temps sur la première phase d’analyse grâce à l’IA.

Il faut savoir que sur l’ensemble des personnes éligibles, il y a entre 1 et 3% de cas de cancer. Cela paraît peu, c’est pourtant beaucoup car souvent ce dépistage intervient tardivement. D’où l’importance de pouvoir focaliser l’attention des radiologues là où c’est nécessaire. Si les radiologues sont convaincus du bénéfice de l’IA comme complément à leur expertise, l’IA viendra alors en première analyse pour distinguer les scanners problématiques des autres. A terme, nous voudrions donc pouvoir leur proposer un outil abouti, qui soit utilisable dans la pratique clinique.

Quels outils utilisez-vous ?

Je code essentiellement en Python, avec des librairies connues pour l’apprentissage profond comme Tensor Flow ou Keras. J’utilise aussi des librairies de machine learning au sens large, de computer vision, de calcul statistique. On apprend à une machine à faire la tâche, mais on doit pouvoir évaluer le résultat, et donc savoir si les nodules ont été correctement identifiés. En cas d’erreur, on risque soit de manquer un cas de cancer avéré, soit de l’identifier à tort et de déclencher une biopsie qui n’est pas nécessaire.

Utilisez-vous des infrastructures Cloud ?

Je travaille sur des serveurs alloués au projet. Pour le moment, on évite le Cloud pour des questions réglementaires, la question du Cloud reste ambiguë dans le domaine de la santé.

Quelles sont vos contraintes sur la partie computer vision ?

Ce sont les ressources de calcul demandées par le Deep Learning, qui sont de plus en plus coûteuses. C’est pour cela que je dois aussi répondre à des appels à projet, parfois dédiés au budget matériel, pour avoir une infrastructure capable de supporter les calculs.

Cela soulève aussi la question de l’impact environnemental. On peut lancer des centaines de calculs, peut-être pas tous logiques ou intéressants, parfois en lancer plusieurs simultanément pour évaluer plus rapidement l’algorithme. Est-ce que cela justifie d’investir autant en GPU, ou bien est-il préférable de réfléchir plus longtemps sur le bien fondé de l’algorithme ? D’un autre côté, on fait face à des géants du domaine, les GAFAM, qui ont suffisamment de moyens pour acheter le matériel nécessaire au travail de leurs équipes d’experts. C’est un dilemme.

Quelle est la longueur du cycle de développement de ces modèles ?

On peut voir les choses de deux façons. Soit on veut être au sommet de l’élégance mathématique du modèle, et améliorer sensiblement les performances. Soit on essaie de faire au mieux dans un temps plus contraint, pour proposer une solution efficace. Et dans ce cas, il me semble qu’il n’y a que quelques exemples d’architecture qui ont fait leur preuves dans d’autres communautés, et qu’il faut adapter et réutiliser. Dans ce cas, on passera quelques mois à peaufiner ce modèle par rapport aux données. Mais le cœur de notre travail consiste à comprendre les données initiales et l’enjeu du problème. Quand cet enjeu est compris, on est à même d’identifier des algorithmes qui ont déjà fait leurs preuves, et qui sont pertinents dans notre cas d’usage. Ensuite, on améliore, on vérifie, on teste les résultats… c’est une évolution constante, nous devons pouvoir quantifier l’incertitude associée au résultat. C’est ce qui me semble le plus important. Tout cela fait qu’on est sur un cycle de développement d’environ un an pour avoir des premiers résultats.

Et le podcast Horizon IA ?

C’est à l’origine une idée de Syntyche Gbehounou. L’objectif du podcast est de pouvoir expliquer nos métiers à nos proches, qui ont souvent une idée un peu spectaculaire de l’IA. C’est une image entretenue par les médias et les grandes entreprises de la tech, et la plupart des gens ont du mal à imaginer notre quotidien. Oui, l’IA peut être spectaculaire, mais il existe de nombreuses applications très proches de nous, et dont l’impact est positif.

Dans ce podcast, nous interrogeons des gens qui ont un projet d’IA, pour échanger sur les enjeux de leur domaine et leurs défis métiers. Notre objectif est aussi de faire en sorte que les plus jeunes puissent comprendre les enjeux de l’IA, et éventuellement s’intéressent aux métiers de l’IA ou à ceux associés. Il n’y a pas que les métiers du machine learning, dans la robotique par exemple, il y a toute une chaîne de métiers associés à l’IA. Nous voulons aussi sensibiliser les utilisateurs de l’IA à la maîtrise de leurs données et de leur utilisation, aux questions liées aux biais des IA.

Derrière l’IA, se pose la question de la responsabilité de l’humain : sans intelligence humaine, il n’y a pas d’intelligence artificielle. C’est l’humain qui montre à l’algorithme ce qu’il doit apprendre par l’exemple.

L’épisode 20 du Podcast Horizon IA consacré au projet Lung Screen AI :

Vous avez également ouvert une antenne de l’association Women in Machine Learning à Sophia Antipolis. Quelle est aujourd’hui la place des femmes dans les métiers de la Data Science ?

Au vu des chiffres, les femmes sont encore en minorité dans les métiers de la Data Science. Cela dépend des cultures, en Asie par exemple les femmes sont plus nombreuses dans la tech. Mais ici, des initiatives se développent pour faire témoigner plus de femmes, et c’est aussi le but des portraits publiés sur la page de l’association, montrer qu’il y a des femmes avec des parcours divers. On peut commencer son parcours professionnel dans la linguistique, la biologie, ou un autre domaine, et ensuite aller vers l’IA. L’usage des outils d’IA change également, on n‘est plus obligé de savoir coder pour faire de l’IA, il y a de plus en plus d’outils no code. Il existe également des cours en ligne pour se remettre à niveau, l’école 42 en propose par exemple. Le témoignage de femmes qui sont en poste dans ces métiers en incitera d’autres, y compris les jeunes filles qui vont se rendre compte que le métier n’est pas réservé aux garçons. Et qu’il n’est jamais trop tard, quel que soit le parcours de formation, pour faire évoluer ses compétences vers les métiers de l’IA.