AWS Summit 2021, retour sur la keynote

200 sessions, 75 partenaires, 30 cours en ligne et certifications… cette édition 2021 du Summit AWS s’est à nouveau déroulée en distanciel. On est un peu loin de l’ambiance et de l’énergie des Summit de 2019 et des années précédentes, cependant encore une fois le contenu était au rendez-vous, même si le charismatique Werner Vogels a laissé cette année sa place de maître de cérémonie de la keynote d’ouverture à Peter Desantis. Retour rapide sur la keynote.

“There is no compression algorithm for experience”

C’est avec cette citation d’Andy Jassy que Darren Hardman, VP AWS UK Ireland a introduit la keynote d’ouverture avant de rappeler les valeurs sur lesquelles AWS a construit son succès :

- Une approche centrée client

- Une position de pionnier sur le marché, grâce au rythme d’innovation

- Une relation client pensée sur le long terme

EC2 et l’élasticité

Peter Desantis, Senior VP, a ensuite pris le relais depuis Seattle. Au programme de ce début de keynote ? Les instances EC2 et l’élasticité. Le sujet semble évident pour qui est un minimum familier du Cloud, cependant au regard de la crise de 2020, la capacité à scaler a été un facteur déterminant dans le succès d’entreprises comme Netflix et Zoom, qui ont vu à cette occasion leur demande exploser.

L’occasion de rappeler les conditions dans lesquelles le service EC2 a été créé en 2006 : Peter Desantis a ressorti la documentation de l’époque pour exposer les grands principes écrits du service. Cela tient en quelques mots, EC2 devait être : sécurisé, fiable, élastique, flexible, économique et facile d’utilisation.

Autant de points qui sont encore aujourd’hui des arguments de vente pour AWS : l’élasticité est un aspect de la disponibilité, depuis le lancement d’AWS les tarifs ont baissé plus de 100 fois, etc. Plus important, la flexibilité et la liberté pour les développeurs d’explorer de nouveaux outils, et là le catalogue de services Analytics, IoT, calcul, etc. parle pour lui-même.

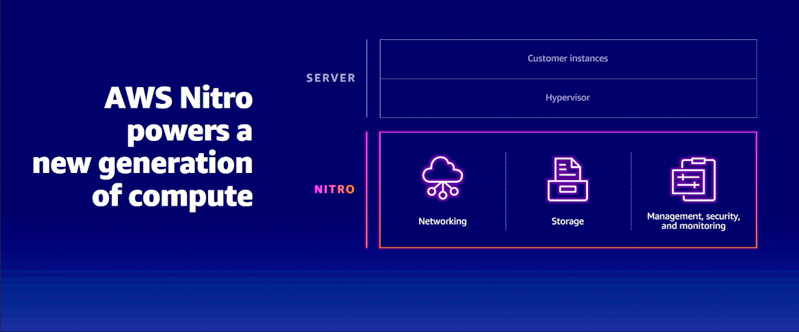

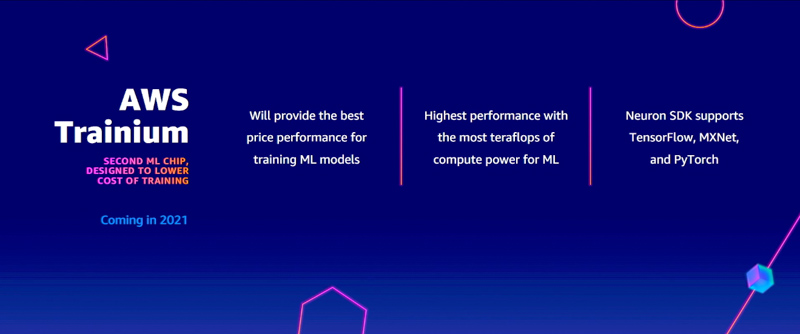

Focus donc sur l’offre de Compute à ce jour, qui a évolué en trois grandes catégories : les instances EC2, les conteneurs, et le serverless. EC2 est le plus ancien, et aussi l’un des plus “basiques” services d’AWS, cependant il est encore une vitrine technologique et un laboratoire d’innovation. AWS a ainsi complètement revu la couche de virtualisation des instances EC2 avec le système Nitro, permettant ainsi d’augmenter les performances et de réduire les coûts. Les puces personnalisées, ont également permis de segmenter un peu plus l’offre : aujourd’hui AWS propose 3 types de puces pour ses instances, Graviton 2 pour le scale out, Inferentia pour le Machine Learning, et Trainium pour l’entraînement des modèles (sortie en 2021).

Cas client : Flying Whales

Pour illustrer le rôle du calcul dans l’innovation, c’est un projet hors-normes qui a été présenté. Flying Whales, entreprise française, ambitionne de révolutionner le transport de marchandises (jusqu’à 60 tonnes) avec des dirigeables de 200 mètres sur 50.

Cette solution de transport cargo s’appuie sur une propulsion hybride électrique, et sur des appareils permettant le chargement et le déchargement en vol. Parmi les cas d’usage, la livraison point à point, l’intervention en urgence quand les infrastructures sont détruites, le déchargement depuis des sites inaccessibles, etc. Le premier vol aura lieu en 2024, et le coût du programme est similaire à celui des gros porteurs de l’aviation civile.

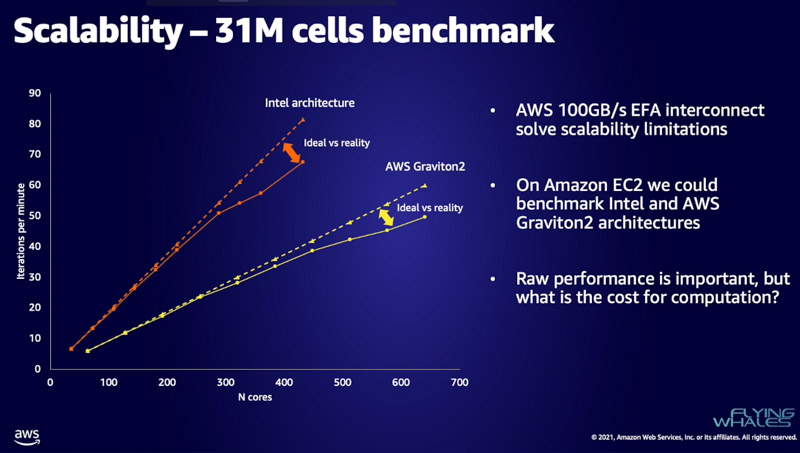

En l’absence d’historique de données, le développement du projet repose donc fortement sur les simulations, et c’est ici qu’entre en jeu le calcul haute performance sur AWS. Comme l’explique Vincent Guibout, Vice CEO de Flying Whales, l’entreprise utilise le calcul sur AWS pour ses opérations de CFD (computional fluid dynamics), c’est-à-dire la prédiction des charges, de la taille, de la structure… pour chaque simulation, ce sont 300 zones d’arrêt et de calcul, avec pour chacune 40 à 60 millions de points. Le passage dans le Cloud pour réaliser les calculs de CFD, notamment via des instances EC2 spot, a permis à Flying Whales de répondre aux enjeux de scalabilité, avec des résultats 15 fois plus élevés qu’une solution on premise (voir slides ci-dessous).

Les conteneurs, c’est dans la boîte

Selon Peter Desantis, 80% des conteneurs aujourd’hui dans le Cloud tournent sur AWS, qui propose trois options de conteneurs : EKS, une plateforme managée Kubernetes, ECS, l’offre propriétaire AWS, avec une forte intégration au reste de l’écosystème AWS, et Fargate, qui permet d’exécuter des conteneurs sans se soucier de la couche serveur, une offre conteneurs serverless donc. La croissance de la demande est forte : la plupart des clients d’AWS utilisent au moins deux services de conteneur sur les trois disponibles.

La data, le nerf de la guerre

Impossible de faire l’impasse sur le sujet de la Data, et c’est Dorothy Li VP BI & Analytics, qui prend le relais. A l’agenda de la majeure partie des entreprises, comment tirer plus de valeur de ses données? Nous avons tous conscience de la croissance effrénée du volume de données produits : Dorothy Li rappelle tout de même qu’aujourd’hui, on produit en une heure plus de data que sur toute une année il y a 20 ans ! L’enjeu pour les entreprises est de devenir “data driven”, ce qui signifie que :

- La data est vue comme un asset organisationnel

- La data est démocratisée : on sort de la logique des silos de données, et la data est accessible à tous ceux qui en ont besoin

- La data est exploitée, on la fait travailler avec le ML

Dans ce chemin vers la data, AWS recommande de migrer vers des datastores flexibles, et de choisir ses bases de données en fonction des spécificités des cas d’usage, et de ne pas nécessairement se limiter aux bases de données relationnelles. Aurora, RDS, DynamoDB, Elasticache, Neptune, Quantum Ledger Database, Timestream, DocumentDB… la largeur de l’offre de bases de données d’Amazon permet de répondre à tous les cas de figure ou presque.

De la data au Machine Learning

Après un rapide focus sur la construction de datalake, basée sur S3, citée comme “la meilleure solution pour construire un datalake”, combinée à Athena, Amazon EMR (pour le data processing), Kinesis pour le traitements temps réel , ou Redshift pour le datawarehousing, on enchaîne assez logiquement sur le Machine Learning.

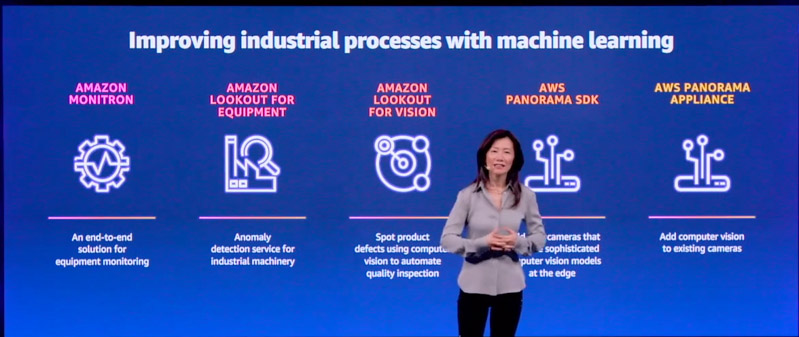

AWS propose trois stacks de Machine Learning :

- Services managés : des services managés prêts à l’emploi (traduction, analyse de documents, analyse d’images, reconnaissance vocale, etc.)

- Sagemaker, pour créer et entraîner ses modèles, avec de nombreux services dédiés (Ground Truth pour l’étiquetage, Feature Store un référentiel de caractéristiques de ML, Monitor pour corriger les dérives de modèle, Pipelines pour le CI/CD, etc.)

- Infrastructure de ML, frameworks et bibliothèques de ML : TensorFlow, PyTorch, Apache MXNet et autres frameworks

Peter Desantis cite ainsi l’exemple d’ADP, qui a réduit le temps de déploiement des modèles de ML de deux semaines à une journée avec Sagemaker.

Bundesliga et Machine Learning

Andreas Heyden, de la ligue nationale de football allemande (DFL), a ensuite présenté le rôle du Machine Learning dans l’innovation autour de l’expérience Bundesliga. Des chronomètres au passage à la TV en couleurs, le sport a toujours été un terrain naturel pour l’innovation; depuis 2018, la DFL s’emploie à développer de nouveaux services, dont le succès repose entre autres sur la capacité à scaler.

Bundesliga Match Facts Goals par exemple, affiche différentes analyses en temps quasi réel, quelques secondes après un but. Attacking Zones permet de comprendre comment le jeu se déroule, et les changements de stratégie en direct; dans le même ordre d’idée, Realformations montre les repositionnements des joueurs après un remplacement. Pour parvenir à ce résultat, 10 000 matchs d’archive ont été utilisés pour entraîner les modèles, et plus de 1600 événements data sont ajoutés à chaque match.

Pour revoir l’ensemble des keynotes et atelier en vidéo à la demande :